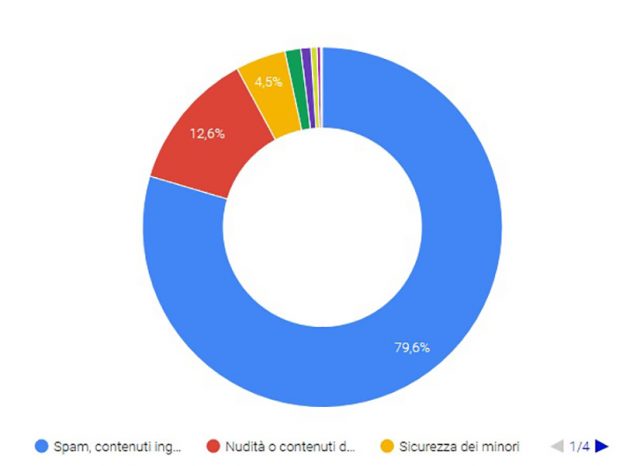

Nell’ultimo rapporto trimestrale (luglio-settembre 2018) diffuso da YouTube, la piattaforma di video sharing di proprietà di Google, si è avuta conferma della rimozione oltre 7,8 milioni di video che non rispettavano le linee guida della community. Si parla tendenzialmente di contenuti ingannevoli e truffe (79,6%), nudità o contenuti di natura sessuale (12,6%), sicurezza dei minori (4,5%) e promozione della violenza (0,6%). Nello stesso periodo e per i medesimi motivi inoltre sono stati chiusi anche oltre 1,6 milioni di canali e rimossi oltre 224 milioni di commenti, in gran parte legati a spam.

L’aspetto più interessante però è che ben l’81% di questi video è stato segnalato dai sistemi di intelligenza artificiale basati sul machine learning, il 74.5% addirittura prima di aver ricevuto anche una sola visualizzazione.

Molto interessante in quest’ottica anche il fatto che in due aree particolarmente sensibili, come i contenuti riguardanti estremismo violento e pedofilia, la percentuale di video caricati e rimossi prima di avere più di 10 visualizzazioni sia pari addirittura al 90%. Un segnale quindi di buona tempestività, anche se quel 10% rimanente rimane una sfida tecnologica.

“Abbiamo sempre utilizzato un mix di tecnologia e revisori per identificare i contenuti che violano le norme sulla nostra piattaforma, e nel 2017 abbiamo cominciato ad utilizzare una tecnologia di machine learning più avanzata per segnalare i contenuti da sottoporre alla revisione dei nostri team”, si legge sul blog ufficiale. “Questa combinazione di tecnologia di rilevamento intelligente e personale umano altamente qualificato ci ha permesso di applicare con più costanza le nostre linee guida, aumentando al contempo la velocità di intervento”.

Insomma, dopo le forti pressioni subite tra il 2016 e il 2017 sia da parte dell’Unione Europea che dai singoli Stati, YouTube ci tiene a sottolineare come la propria capacità di “censura” preventiva sia molto migliorata nel tentativo di arginare la diffusione sulle proprie pagine di contenuti illegali e pericolosi.

Articolo Precedente

Smartphone venduti in Europa con supporto Galileo obbligatorio, per una localizzazione più precisa di chi chiama il numero di emergenza 112

Articolo Successivo

Recensione Xiaomi Mi 8 Lite: design ricercato e colori sgargianti in grado di catturare i millennial, ma la qualità fotografica convince meno